摘要:网站结构若过于繁杂无序,百度搜索引擎的爬虫可能难以准确抓取关键信息。此外,内部链接的设置同样关键,合理的内链布局有助于爬虫更深入地了解网站内容。页面的加载速度对收录确实有影响。因此,我们需要优化代码,压缩图片等,以提升加载速度。

百度不收录使用https协议的网站,这让众多网站管理者感到烦恼。尽管https是一种更为安全的网络传输方式,但百度可能并不会将其收录,这种情况可能由多种原因造成。

网站结构问题

网站结构若过于繁杂无序https百度不收录,百度搜索引擎的爬虫可能难以准确抓取关键信息。就像在迷宫中寻找路径,一旦结构杂乱,便容易迷失方向。因此,我们需要对网站结构进行优化,确保导航简洁明了,链接布局合理,使得每个页面都能轻松被爬虫访问。此外,内部链接的设置同样关键,合理的内链布局有助于爬虫更深入地了解网站内容。

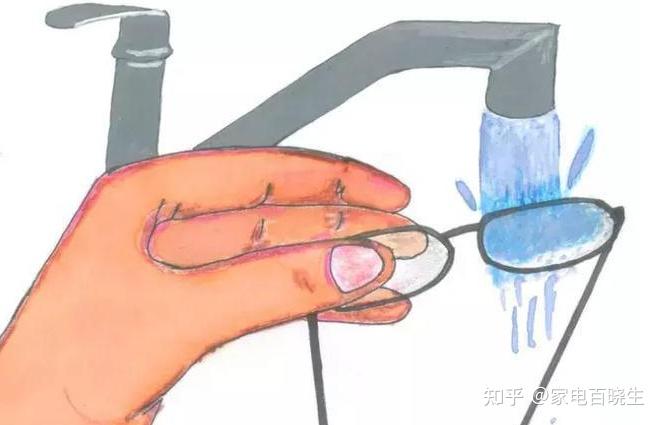

页面的加载速度对收录确实有影响。若加载过慢,爬虫可能就会放弃收录。这就像顾客等在商店门口太久后选择离开。因此,我们需要优化代码,压缩图片等,以提升加载速度。

内容质量是关键

好的内容能够吸引百度的关注。若是内容多为抄袭或质量不高,百度不予收录也在情理之中。因此,我们需要创作出独到且富有价值的作品。比如,一篇深入的行业分析文章就是一个很好的例子。

内容更新的速度不能太慢。若网站长时间没有新内容,百度可能会觉得它缺乏生机,从而不太乐意将其收录。所以,定期发布新颖的内容对于维持网站的吸引力至关重要。

技术配置查看

确保robots.txt文件配置无误是一项关键操作。这个文件相当于一扇门,一旦设置不当,就会将爬虫阻挡在外。

确保HTTPS证书无误。若证书出现问题https百度不收录,百度可能会认为存在安全隐患,从而选择不进行收录。

外部因素影响

网站的域名过往记录和信誉状况同样重要,对收录结果有影响。若网站曾有过违规行为,新站可能会因此受到偏见对待。

同行网站带来的竞争不容忽视,若他们有更出色的优化,百度可能会优先考虑他们。

遇到百度不收录HTTPS站点的问题吗?欢迎留言谈谈你的遭遇,若觉得这篇文章对你有帮助,请点赞并转发。